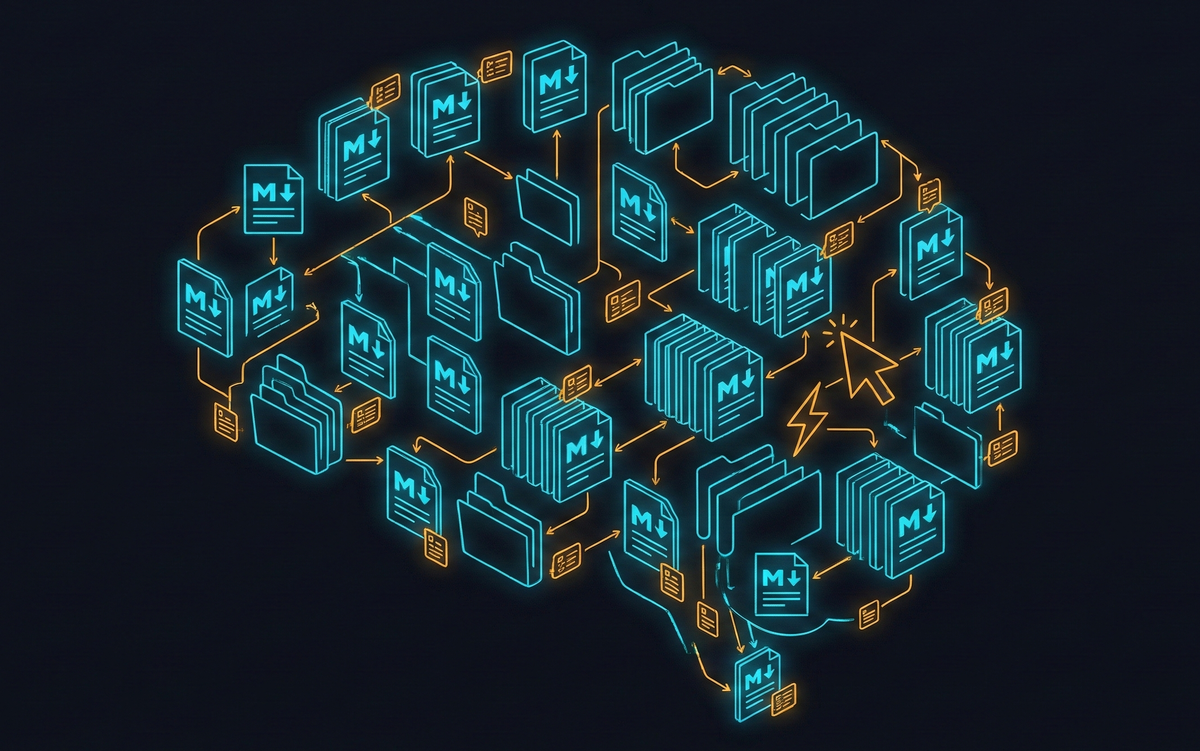

你的第二大腦,應該為 AI 而建

IDE 還是 Obsidian?這個問題問錯了。真正的問題是你的資料能不能活得比工具久

我用 Notion 和 Heptabase 很多年了

兩個工具我都覺得很好,

Notion 拿來做專案管理和 Life OS,

Heptabase 拿來做思路整理和拉知識關聯。

這種重新組織內容、擷取重點的過程,

本身就是很有價值的思考訓練方式。

問題是我沒辦法持續做這件事。

整理一份研究素材,要想分類、下標籤、拉連結、確認跟其他筆記的關係

做一次很有收穫,但要定期回來檢視和維護,

真的會需要花不少時間。

結果就是用了一陣子就荒廢,隔幾個月再打開,

又要花時間搞清楚之前整理到哪裡斷斷續續的,

知識庫一直長不起來。

後來開始認真做內容輸出,素材量一下子暴增,

維護結構的時間比研究本身還多,

我知道這樣下去不行。

轉折點不是來自筆記工具

讓我改變做法的,其實是開發工作

這段時間大量用 LLM CLI 工具在做產品開發,

寫著寫著發現,設計規格文件的方式,

結構化的 Markdown 加上 metadata,

其實跟知識管理需要的東西很像。

而 AI 在檔案處理上的能力在這幾個月根本是飛躍式的提升,

它可以直接讀你的檔案、理解結構、幫你重新組織內容、補上交叉連結,

那些在 Heptabase 裡需要我手動花時間做的事,AI 可以幫忙處理掉大部分,

同一時間也看到有人分享用 IDE 和 Obsidian 搭配 AI 做第二大腦,

我覺得時機到了。

搬筆記的時候我發現一件事

整個遷移過程中,花最多時間的是思考跟重建流程,

自動化腳本要重寫,索引邏輯要重新設計,

跟 AI 的協作方式也要重新摸索,

但筆記轉換成 Markdown 格式後,

一個檔案都不用動直接搬過來就能用,

不依賴任何工具的專屬格式,

不管用什麼軟體打開,內容都在。

那個瞬間我才真正意識到這些年累積下來,

真正有價值的不是我在哪個工具裡建好的流程,

是那些筆記本身。

流程會一直被改寫,資料不會

AI 工具的更新速度快到,你上個月建好的工作流程,

這個月可能就要調整,有人花兩週調好一套提示工程模板,

三個月後模型更新,效果不如一句簡單指令。

我原本是用 Readwise 搜集資料來源,整合其他知識管理工具,

現在轉換成 Markdown + AI 協作模式,說實話處理起來更有效率。

也許半年後又有新工具出現,整套又要大改。

你以為建好自動化是一種資產,

其實每次工具更新,舊的流程就在貶值,

但資料不一樣,

只要格式開放、結構清楚,

不管工具怎麼換,筆記都還能用。

我從 Heptabase 搬出來的那些筆記,

現在可以自由在 IDE 或是 Obsidian 中,透過 AI 的方式自由切換。

IDE 還是 Obsidian?

這是我搬的過程一值思考的工具選擇問題?

兩個都讀 Markdown,都存在本機,選哪個差別不大,

真正有差別的是:你的資料用什麼格式存、存在哪裡、你自己能不能控制。

筆記用開放格式寫,不鎖在任何平台裡,

檔案放在自己的電腦上,不是只存在某個雲端服務,

每份筆記帶上基本的結構資訊,讓 AI 或未來任何工具都能快速理解。

做到這些之後,AI 可以幫你做到以前做不到的事。

這幾天把朋友給的 PC 市場數據丟進知識庫,

AI 自己把它跟我之前寫的半導體研究筆記對在一起,

找到一個我還沒想到的跨領域關聯。

兩份資料格式不同、來源不同、寫的時間也不同,

是 AI 同時讀得到兩邊,才把連結找出來。

但前提是那些筆記要用 AI 讀得懂的格式存好,

如果鎖在某個平台的專屬資料庫裡,這件事做不到。

順帶一提,Notion 和 Heptabase 我還是在用,

Notion 放生活系統和專案協作,

Heptabase 在需要深度思考和視覺化的時候還是很好用,

只是知識庫這一塊,我選擇用 AI 能直接協作的方式來建。

更有趣的是,我還可以透過 MCP 來管理跟更新 Notion 跟 Heptabase 的資料。

那直接問 AI 就好,為什麼還要自己建?

AI 的記憶越來越好,ChatGPT 已經有跨對話記憶,

感覺 AI 自己就能記住你講過的東西。

但那些記憶是平台的,不是你的,

換一個模型,記憶帶不走,

平台改了政策,資料不一定還在。

我覺得更根本的是,

如果知識全部存在 AI 的記憶裡,

你會慢慢搞不清楚自己到底知道什麼。

自己持有一份看得到的知識庫,

不只是備份,

是讓你清楚自己的知識長什麼樣。

工具會換,流程會改寫

但你的資料,只要格式開放、結構清楚,會一直留下來,

這才是第二大腦真正值得投資的地方。